โมเดลภาษาขนาดใหญ่ Free และ Opensource เพื่อคนไทยทุกคน

🇹🇭 OpenThaiGPT 1.6 72b โมเดลภาษาขนาดใหญ่รุ่นล่าสุด ได้รับการปรับปรุงจากรุ่น 1.5 และ 🧠 OpenThaiGPT R1 32b โมเดลด้านการคิดวิเคราะห์และให้เหตุผล และพร้อมให้บริการแล้ว โมเดลนี้ได้รับการพัฒนาเพื่อการใช้งานทั่วไปและมีความสามารถด้านการคิดเชิงเหตุผลที่แข็งแกร่ง โดยเฉพาะอย่างยิ่งในภาษาไทย

ทดลองใช้งานผ่าน ChindaX: https://chindax.iapp.co.th

OpenThaiGPT 1.6 72b: OpenTHaiGPT R1 32b:

OpenThaiGPT 1.6 72b เป็นโมเดลภาษาไทยขนาด 72 พันล้านพารามิเตอร์ ที่ออกแบบมาสำหรับงานทั่วไปพร้อมความสามารถในการคิดวิเคราะห์ที่แข็งแกร่ง ต่อยอดจากพื้นฐานของ OpenThaiGPT 1.5 รุ่นล่าสุดนี้แสดงให้เห็นถึงประสิทธิภาพที่ดีขึ้นในการทดสอบหลากหลายรูปแบบ โดยเฉพาะอย่างยิ่งในด้านการเขียนโค้ดและงานด้านภาษาทั่วไป

โมเดลภาษาไทยขั้นสูง ด้วยพารามิเตอร์ 72 พันล้าน

ความสามารถในการคิดวิเคราะห์ที่แข็งแกร่ง ทั้งในภาษาไทยและภาษาอังกฤษ

ประสิทธิภาพที่ดีขึ้น เมื่อเทียบกับรุ่น OpenThaiGPT ก่อนหน้านี้

ความสามารถที่สมดุล ทั้งด้านคณิตศาสตร์ การเขียนโค้ด และงานด้านภาษาทั่วไป

เมื่อเทียบกับ OpenThaiGPT 1.5 72b รุ่น 1.6 แสดงให้เห็น:

ประสิทธิภาพด้านการเขียนโค้ดที่ดีขึ้นอย่างมาก ทั้งในภาษาไทย (LiveCodeBench-TH: 32.43 เทียบกับ 12.61) และภาษาอังกฤษ (LiveCodeBench: 54.21 เทียบกับ 46.38)

ความเข้าใจภาษาทั่วไปที่เทียบเคียงกัน ด้วยความแม่นยำด้านภาษาสูงถึง 98.2%

ความสามารถที่สมดุลดีขึ้น ระหว่างงานด้านคณิตศาสตร์และการเขียนโค้ด

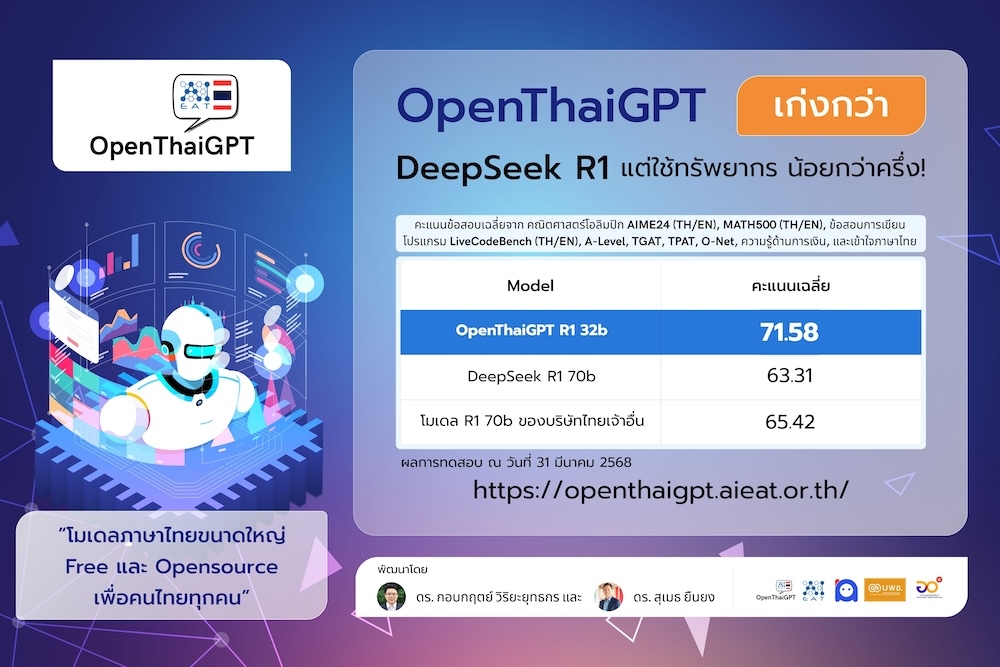

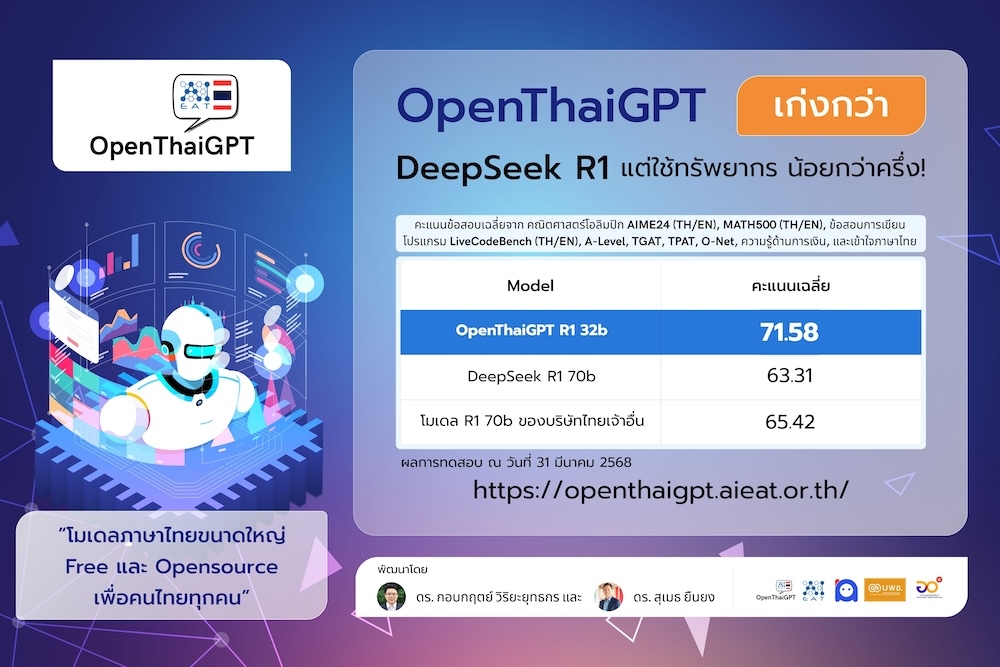

OpenThaiGPT R1 32b เป็นโมเดลภาษาไทยขั้นสูงขนาด 32 พันล้านพารามิเตอร์ที่เน้นด้านการคิดวิเคราะห์และให้เหตุผล ซึ่งมีประสิทธิภาพสูงกว่าโมเดลขนาดใหญ่อย่าง DeepSeek R1 70b และ Typhoon R1 70b แม้จะมีขนาดเล็กกว่าครึ่งหนึ่ง โมเดลนี้เชี่ยวชาญในงานที่ต้องใช้การคิดวิเคราะห์ซับซ้อน รวมถึงคณิตศาสตร์ ตรรกะ และการเขียนโค้ดในภาษาไทย

โมเดลภาษาไทยที่ทันสมัยที่สุด มีประสิทธิภาพสูงกว่าโมเดลขนาดใหญ่ในการทดสอบด้านคณิตศาสตร์และการให้เหตุผลเชิงตรรกะ

ความสามารถในการให้เหตุผลอย่างชัดเจน สามารถแสดงกระบวนการคิดเป็นขั้นตอนได้

ขนาดเล็กกว่าอย่างมีนัยสำคัญ (32b) แต่มีประสิทธิภาพสูงกว่าโมเดลขนาด 70b

เชี่ยวชาญด้านการคิดวิเคราะห์ในภาษาไทย รวมถึงปัญหาคณิตศาสตร์และตรรกะที่ซับซ้อน

If OpenThaiGPT has been beneficial for your work, kindly consider citing it as follows:

Install VLLM ()

Run server (เลือกอันใดอันหนึ่ง)

Note, change --tensor-parallel-size 2 to the amount of available GPU cards.

Run inference (CURL example)

หรือเปลี่ยนชื่อโมเดลเป็น "model": "openthaigpt/openthaigpt-r1-32b-instruct" หรือ "model": "openthaigpt/openthaigpt-1.6-72b".

โมเดลนี้มีให้ใช้สำหรับ การวิจัย และ การใช้งานเชิงพาณิชย์ ภายใต้เงื่อนไขสัญญาอนุญาติ Qwen2.5 โปรดดูไฟล์ LICENSE สำหรับข้อมูลเพิ่มเติม

เว็บไซต์อย่างเป็นทางการ:

เพจ Facebook:

เซิร์ฟเวอร์ Discord สำหรับการสนทนาและสนับสนุน

อีเมล:

ดร. กอบกฤตย์ วิริยะยุทธกร ([email protected] / [email protected])

ดร. สุเมธ ยืนยง ([email protected])

ดร. ทศพร ฉายอินทร์ ([email protected])

ได้รับการสนับสนุน GPU Nvidia H100 x 8 ใบ จากบริษัท สยาม เอไอ คอร์เปอเรชั่น จำกัด:

ได้รับทุนวิจัยสนับสนุนจากกองทุนส่งเสริมวิทยาศาสตร์ วิจัยและนวัตกรรม โดยหน่วยบริหารและจัดการทุนด้านการเพิ่มความสามารถในการแข่งขันของประเทศ (บพข.) ร่วมกับ บริษัท ไอแอพพ์เทคโนโลยี จำกัด ซึ่งมี สมาคมผู้ประกอบการปัญญาประดิษฐ์ประเทศไทย เป็นผู้ดำเนินงานโครงการ

Disclaimer: Provided responses are not guaranteed.

ความเข้าใจที่ลึกซึ้ง ในภาษาไทยและบริบททางวัฒนธรรม

ประสิทธิภาพสูงในการเขียนโค้ด ทั้งในภาษาไทยและภาษาอังกฤษ

0

AIME24

23.33

6.67

10

23.33

6.67

3.33

10

0

MATH500-TH

43.2

24.2

26.2

62

51.8

31

55.8

21.8

MATH500

82

40.4

47.4

83.2

65.4

49.6

67.4

42.8

LiveCodeBench-TH

32.43

22.52

21.62

12.61

9.91

8.11

27.03

0

LiveCodeBench

54.21

31.12

37.96

46.38

0.98

5.87

37.38

0

OpenThaiEval

78.7

64.5

71.26

77.16

64.76

56.63

72.54

65.27

Language Accuracy

98.2

97.6

98.4

99.4

99.4

98.6

99.8

98.6

AVERAGE

52.34

35.88

39.11

51.34

37.78

32.06

47.91

28.56

MATH500

89.4

88.88

90.2

LiveCodeBench-TH

62.16

53.15

47.75

LiveCodeBench

69.67

64.97

54.79

OpenThaiEval

76.05

74.17

77.59

AVERAGE

71.58

63.31

65.42

Benchmarks

OpenThaiGPT 1.6 72b

OpenThaiGPT 1.5 7b

OpenThaiGPT 1.5 14b

OpenThaiGPT 1.5 72b

Typhoon2 Qwen2.5 7b

Typhoon2 Llama3.1 8b

Typhoon2 Llama3.1 70b

NECTEC Pathumma LLM Text 1.0.0 7b

AIME24-TH

6.67

0

0

6.67

3.33

3.33

SkyThought

OpenThaiGPT R1 32b

DeepSeek R1 70b

Typhoon R1 70b

AIME24-TH

56.67

33.33

53.33

AIME24

63.36

53.33

53.33

MATH500-TH

83.8

75.4

81

จำนวนพารามิเตอร์

FP 16 bits

8 bits (Quantized)

4 bits (Quantized)

32b

64 GB

32 GB

16 GB

72b

144 GB

72 GB

36 GB

13.33

@misc{yuenyong2025openthaigpt16r1thaicentric,

title={OpenThaiGPT 1.6 and R1: Thai-Centric Open Source and Reasoning Large Language Models},

author={Sumeth Yuenyong and Thodsaporn Chay-intr and Kobkrit Viriyayudhakorn},

year={2025},

eprint={2504.01789},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={https://arxiv.org/abs/2504.01789},

}from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "openthaigpt/openthaigpt-1.6-72b" #openthaigpt/openthaigpt-r1-32b-instruct

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

prompt = "กรุงเทพมหานครคืออะไร"

messages = [

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(

**model_inputs,

max_new_tokens=8192,

temperature=0.6

)

generated_ids = [

output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)

]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]vllm serve openthaigpt/openthaigpt-1.6-72b --tensor-parallel-size 2

vllm serve openthaigpt/openthaigpt-r1-32b-instruct --tensor-parallel-size 2curl -X POST 'http://127.0.0.1:8000/v1/chat/completions' \

-H 'Content-Type: application/json' \

-d '{

"model": "openthaigpt/openthaigpt-1.6-72b",

"messages": [

{

"role": "user",

"content": "กรุงเทพมหานครคืออะไร"

}

],

"max_tokens": 4096,

"temperature": 0.6,

"top_p": 0.95,

"top_k": 40

}'